‘Ses’li tuzak! Defne Samyeli de mağdur oldu

28.01.2024 - 07:00 | Son Güncellenme:

Sahtekârlar, siyasetçilerin ve sanatçıların sesleriyle görüntülerini yapay zekayla kopyalayıp kullanıyor. Bu tehlikeye karşı uzmanın sesine kulak verdik.

GÜLDEN ÇOKTAN - Sanal dünyanın sahtekârları, artık yapay zekayla ürettikleri sahte görselleri ve ses kopyalarını kirli amaçları için kullanıyor.

Yapay zeka destekli ses klonlama (kopyalama) sahtekârlıkları artarken, Türkiye’de de siyaset ve sanat dünyasından birçok kişinin sesi kullanılarak sahte videolar servis edildi. Ses klonlama teknolojisindeki tehlike giderek artarken, uzmanlar, bu videoların sahte olup olmadığını anlamanın mümkün olduğunu söyledi.

NASIL YAPIYORLAR?

Bilgisayar programıyla bir kişinin sesini yapay olarak kopyalamak mümkün. Bunun için yazılıma, hedef alınan kişinin kaydedilmiş sesi yükleniyor ve klavye ile yazılan her şey bu kişinin sesiyle söyletilebiliyor. Yazılıma yüklenen ses analiz edilerek, konuşma biçimi, ses rengi, tonu, nefes sıklığı ve vurgular anlamlandırılıyor. Ardından bu bilgiyle hedef kişinin sesi taklit edilerek yeni ses kayıtları üretiliyor. Ayrıca klonlanan sese, öfke, korku, mutluluk, sevgi ya da bezginlik gibi duygular yüklenebiliyor. Dünyada ve Türkiye’de bazı siyasetçilerin ve ünlülerin ses klonlamayla oluşturulan sahte videoları servis edildi.

"ANLAMAK MÜMKÜN"

Yapay zeka ve deepfake teknolojilerinin bazı kötü niyetli kişilerin elinde ses ve görüntü manipülasyonu için kullanılabileceğine dikkat çeken Marmara Üniversitesi İletişim Fakültesi Görsel İletişim Tasarımı Anabilim Dalı Başkanı Prof. Dr. Ali Murat Kırık anlattı: “Öncelikle ses taklidi teknolojisi, bir kişinin sesini analiz ederek benzer bir ses sentezlemeyi sağlar. Taklidi yapılacak kişinin sesinin modeli oluşturulur ve bu sayede başka bir konuşma üzerine bu ses entegre edilir. Diğer bir teknik olan deepfake görüntü manipülasyonu ise derin öğrenme ve yapay zeka kullanarak gerçekçi görüntü manipülasyonu yapmayı sağlar. Dudak eşleştirmesi gibi teknikler, bir kişinin konuşmasını başka bir videoya entegre etmek için kullanılabilir. Ciddi bir teknik bilgiye sahip olmadan belli programlar aracılığıyla ses ve görüntü taklidi işlemi yapılabiliyor. Görüntülerdeki dudak eşleştirmesini gerçekleştirmek sese oranla daha zordur. Bu sebeple görüntü detaylı incelendiğinde içeriğin yapay zekayla oluşturulduğunu anlayabilmek mümkündür.”

DEFNE SAMYELİ MAĞDUR OLDU

Dolandırıcılar, geçtiğimiz günlerde sunucu - şarkıcı Defne Samyeli’nin daha önce yayımladığı bir videosundaki konuşmasını yapay zekâ yöntemiyle değiştirerek bahis sitelerinde “Paranızı artıracağız ve katlayacağız” vaadiyle vatandaşları dolandırmaya çalışmıştı. Durumu fark eden Samyeli, yasal yollara başvurarak takipçilerini uyarmıştı.

‘Tehdit oluşturabilir’

Teknolojinin ilerlemesiyle sahtekârlığın çok daha büyük bir tehdit oluşturacağını belirten Prof. Dr. Ali Murat Kırık, “Seçimler öncesi yapay zeka ve deepfake teknolojilerinin kullanımı, demokratik süreçler üzerinde ciddi etkilere sahip olabilir. Deepfake teknolojisi, siyasi figürlerin görüntülerini manipüle etmek için kullanılabilir. Bu, adayların sözde skandallar içeren sahte videolarla lekelenmesine yol açabilir. Aynı şekilde bu tip yapay görüntüler ve sesler seçmenlerin algılarını etkileyebilir ve seçim sonuçlarını etkilemek için kullanılabilir” dedi.

SEÇMEN'E BIDEN'IN SAHTE SES KAYDO

ABD’nin New Hampshire eyaletinde, 2024 başkanlık ön seçimleri öncesinde sandık başına gidecek seçmene, Başkan Joe Biden’ı taklit eden ses kaydının gönderildiği ortaya çıktı. Savcı, Biden’ın sesinin taklit edildiği kayıtlarla ilgili soruşturma başlattı.

* NASIL ANLARSINIZ?

Prof. Dr. Ali Murat Kırık, ses dolandırıcılığından korunmanın yollarını açıkladı:

- Dudak hareketlerini inceleyin. Ses ile görüntünün eşleşmediği videolara şüpheyle yaklaşın.

- Sosyal medyada yayılan videoları, güvenilir kaynaklarla mukayese edin.

- Telefon veya internette kişisel ve finansal bilgilerinizi vermeyin.

- Güvenilir haber kaynaklarından dolandırıcılıkla ilgili bilgileri edinin.

- Ses kaydında, arka plan gürültüsü olmaması, sesin çok net olması, sesin yapay zeka tarafından oluşturulmuş olabileceğini gösterebilir.

- Yapay zekanın oluşturduğu sesler genellikle duygusuzdur. Sesin duygusal ifadelerine odaklanarak, sesin gerçekliğini değerlendirebilirsiniz.

'KONUŞMA HAZIRLIYORLAR'

Etik hacker Tamer Şahin şunları söyledi: “Yapay zekâ teknolojileri çok ilerledi. Bunda makine öğrenme teknikleri de var. Bu tekniklerle ses ve görüntü kopyalanabiliyor. Ses kaydınızın 20 saniyelik bölümünü verdiğinizde bile özel yazılımlar bunu kopyalayabiliyor. O ses tonuyla 40 dakikalık konuşma bile hazırlanabiliyor. Bazı ünlü konuşmacılar da seslerini satıyor. Böylece ünlü bir konuşmacıdan ses hizmeti satın alıyorsunuz. O sesle istediğiniz konuşma hazırlanıyor. Konuşmayı yapay zekâ gerçekleştiriyor.”

DERİN SAHTEKÂRLIĞA KARŞI YASA ÇAĞRISI

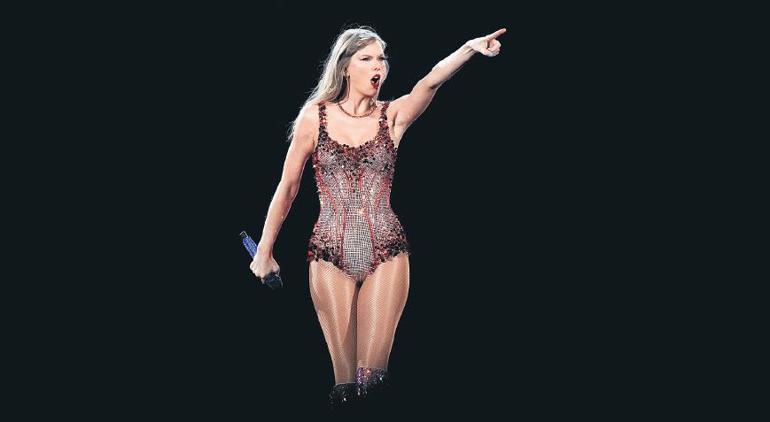

“Deepfake” adlı teknolojik sahtekârlığı kullananlar, bu kez yapay zekayla Taylor Swift’in sahte porno görüntülerini hazırlayıp yayınca siyasetçiler harekete geçti.

Birinin yüz veya vücut görsellerini yapay zekayla değiştirip videosunu oluşturmaya “deepfake” (derin sahtekârlık) deniliyor. Yapay zekanın ortaya çıkışıyla 2019’dan bu yana üzerinde oynanmış görüntülerin (deepfake) oluşturulmasında yüzde 550’lik bir artış olduğu ortaya çıktı.

Bu sahtekârların son kurbanlarından biri de ABD’li ünlü şarkıcı Taylor Swift oldu. Taylor Swift’in yapay zekayla hazırlanan pornografik görüntüleri başta X (Twitter) olmak üzere sosyal medyada yayıldı. Bunun üzerine harekete geçen bazı ABD’li siyasetçiler, deepfake’in önlenmesi için yasa çıkarılması çağrısında bulundu.

KADINLARI KULLANIYORLAR

Temsilciler Meclisi’nde Demokrat Parti temsilcisi Joe Morelle, mahrem görüntülerin deepfake’lerini önleme yasası teklifinin acilen onaylanıp uygulanmasını istedi. Bu sahte görüntülerin geri dönüşü olmayan zararlara neden olduğunu belirten Morelle, “En çok kadınları hedefliyorlar” dedi.

Bir başka Demokrat Temsilci Yvette Clarke de “Kadınlar yıllardır bu teknolojiyle hedef alınıyor, yapay zekayla deep fake oluşturmak çok daha kolay ve ucuz hale geldi” diye konuştu. Cumhuriyetçi Kongre Üyesi Tom Kean Jr da “Kurban kim olursa olsun bu endişe verici eğilimle mücadele etmek şart” ifadesini kullandı.

BEYAZ SARAY: ENDİŞE VERİCİ

ABD Başkanlığı’nın resmi ikametgahı Beyaz Saray’ın basın sözcüsü Karine Jean-Pierre de şunları söyledi:

“Taylor Swift’in sahte görüntülerinin sosyal medyada paylaşılması endişe verici. Bu tür olayların kadınları ve kız çocuklarını derinden etkilediğini biliyoruz. Biden yönetimi, yasal önlemlerle sahte görüntü riskini ortadan kaldırmaya kararlı. Sosyal medya da sahte görüntüleri yaymamalı. ABD yönetimi internetteki tacizle mücadele için çalışma grubu kuracak, 7/24 ihbar hattını hizmete koyacak.”

KALDIRILANA KADAR DEFALARCA GÖRÜNTÜLENDİ

X (Twitter) Taylor Swift’in sahte porno görüntülerinin kaldırıldığını ve bunları yayan hesaplara karşı önlem alındığını açıkladı. Ama sahte görüntülerden birinin bile kaldırılana kadar 47 milyon kez görüntülendiği ortaya çıktı.

ABD’de yayımlanan “State of Deepfakes” adlı resmi rapora göre, internette yayımlanan deepfake’lerin çoğunu pornografi oluşturuyor ve bunların yüzde 99’unda kadınlar kullanılıyor.

Öte yandan Taylor Swift’in hayranları karşı atağa geçerek, X’i şarkıcının kendi normal görselleriyle doldurmak için hızla #ProtectTaylorSwift hashtag’ini paylaştı.